RLLM: 简化多 LLM 集成的 Rust 库

在人工智能领域,大型语言模型(LLM)的应用日益广泛。然而,在实际项目中集成多种 LLM 后端往往面临配置复杂、调用方式不统一等问题。现在,有了 RLLM,一个强大的 Rust 库,可以轻松解决这些难题。

RLLM 的核心价值在于简化多模型集成流程,从而显著提升开发效率。它致力于让开发者能够在一个项目中无缝地集成并使用多种 LLM 后端。

主要特性

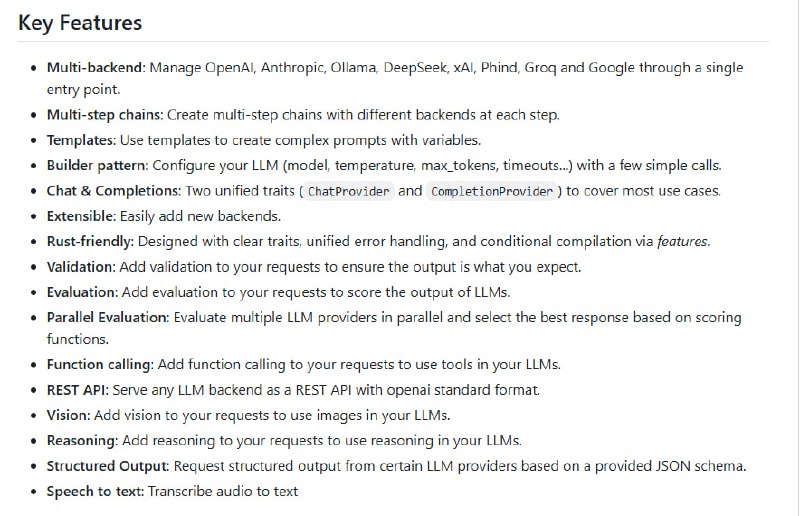

- 广泛的后端支持: RLLM 支持 10 种以上主流 LLM 后端,包括 OpenAI、Anthropic、Ollama 等,覆盖了当前流行的 LLM 服务。

- 统一 API: RLLM 提供统一的 API 接口,简化了配置和调用流程。开发者无需为不同的 LLM 后端编写不同的代码,降低了学习成本和维护难度。

- 灵活的提示与模板: RLLM 内置多步链式提示与模板功能,大幅提升了灵活性。开发者可以根据实际需求,自定义复杂的提示流程,更好地控制 LLM 的输出。

优势

使用 RLLM 可以带来诸多优势:

- 降低集成复杂度: 通过统一的 API,RLLM 简化了多模型集成的过程,减少了代码量和开发时间。

- 提高开发效率: 开发者可以专注于业务逻辑,而无需花费大量精力处理 LLM 后端的配置和调用。

- 增强灵活性: 内置的提示与模板功能,使开发者能够轻松实现各种复杂的 LLM 应用场景。

如果您正在寻找一种简单、高效的方式来集成多种 LLM 后端,那么 RLLM 将是您的理想选择。赶快访问 RLLM 的 GitHub 仓库,了解更多信息并开始使用吧!