langchain-ai/mcpdoc:赋能 IDE,深耕 LLM 上下文

在人工智能驱动的软件开发领域,大型语言模型 (LLMs) 正扮演着越来越重要的角色。然而,要充分发挥 LLMs 的潜力,就需要开发者能够以更精细的方式控制和管理它们。

langchain-ai/mcpdoc 应运而生,它是一个开源项目,旨在将 llms-txt 文件以编程开发工具的形式暴露给集成开发环境 (IDEs)。这意味着开发者不再局限于简单的文本编辑,而是能够在 IDE 中对 llms.txt 文件进行更强大的管理和控制,从而更好地指导 LLMs 的行为。

核心功能与优势

- IDE 集成:

mcpdoc提供 IDE 集成,让开发者可以在熟悉的开发环境中编辑和管理 LLMs 的配置。 - 精细化控制: 通过编程接口,开发者可以动态地调整 LLMs 的参数和行为,实现更精细的控制。

- 上下文增强:

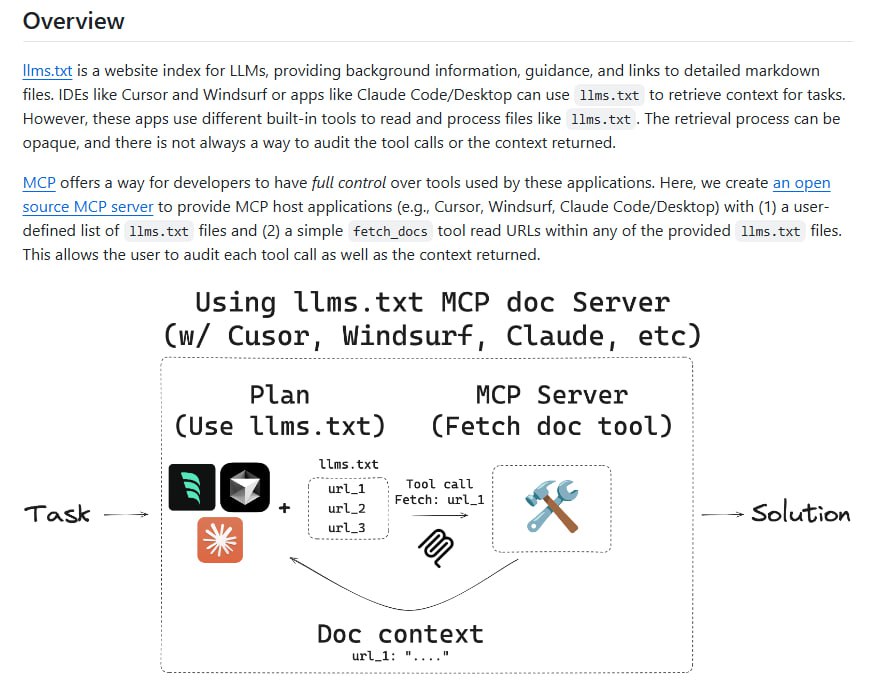

mcpdoc借助开源的 MCP 服务器,让应用程序 (例如 Cursor, Windsurf 或 Claude Code/Desktop) 能够检索到更详细的上下文信息,从而提供更智能的 LLM 辅助。 - 开源社区: 作为一个开源项目,

mcpdoc鼓励社区参与和贡献,共同推动 LLM 开发工具的发展。

工作原理

mcpdoc 的核心在于其 MCP (Meta-Context Provider) 服务器。这个服务器负责索引和管理 LLMs 的配置信息,并向 IDE 和其他应用程序提供上下文数据。通过 API 调用,应用程序可以根据当前开发环境和代码上下文,向 MCP 服务器请求相关的 LLM 配置信息,从而实现更智能的 LLM 辅助。

适用场景

- 代码生成: 基于更精确的上下文信息,LLMs 可以生成更准确、更符合开发者意图的代码。

- 代码审查: LLMs 可以根据特定的编码规范和最佳实践,对代码进行更有效的审查。

- 问题解答: 在开发过程中,LLMs 可以根据更全面的上下文信息,为开发者提供更准确的问题解答和技术支持。

如何开始

mcpdoc 项目托管在 GitHub 上。您可以访问该仓库,了解更多关于项目的信息、安装指南和使用示例。

结语

langchain-ai/mcpdoc 代表了 LLM 开发工具的未来方向,它将 LLMs 的控制权交还给开发者,并借助上下文增强技术,显著提升 LLMs 的智能化水平。相信在 mcpdoc 的助力下,开发者能够更好地利用 LLMs,创造出更优秀的软件应用。